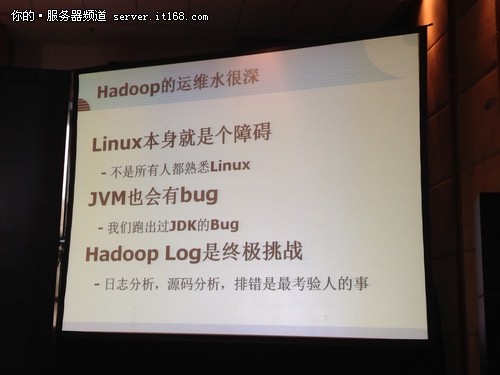

Hadoop的运维水很深

Hadoop本身一个运维,从我这几年运维Hadoop经验来说,这里面的水很深的,坑比较多,我们自己也是一步一步走过来的。Linux本身是一个障碍,不能所有的人会使用Linux的命令行。你会遇到各种各样的问题,JVM也会有bug,也可能是Hadoop的,也可能是分析语言的脚本的。可能连JDK也会有Bug的。Hadoop Log对用户本身来说是很大的一个挑战,要去解决你所遇到的问题,就要去看日志,去分析Hadoop的一个源码,排错,这些是最考验人的事。

中间会遇到很多的问题。VPN、VLAN、Route、Switch的问题。还有一些算法,我们遇到过很严重的鼓掌,最后一查下来,Hadoop的日志里面,什么都没有记。最后我们从操作系统Syslog里抓出来的gdb系列。Hadoop是很大的生态系统源码,各种日志,都是能把人活活逼死的。因为Hadoop本身是大数据的生产者。我们的集群上每个服务器大概都要生产出两个G左右的日志。Hadoop自己也是大数据的生产者,要解决Hadoop的问题,就需要去分析整个Hadoop的日志。

我个人的一个看法,Hadoop以及Hadoop整个的周边生态,不管是哪家公司,增加整个一个Hadoop生态系统的应用性,对用户的友好性才是最重要的事。不能让一个金凤凰总是停留在梧桐枝上,还是需要她飞下来走向千家万户的。我们自己有开源世界,找到开源的东西,找到各种排列组合,加上自主研发的东西,我们自己会进入大数据的一个世界。

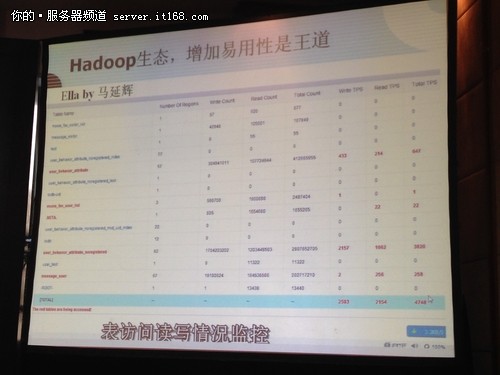

Hadoop生态,增加易用性是王道

下面我讲一下大数据所见即所得,也是我们整个团队开源的所有的东西。我非常支持一个观点,我们是百分之百开源的。这个也是我们阿帕奇项目一个代码的贡献者,Hadoop生态,增加易用性是王道。我们直接开放给所有的产品人员和运营人员用,他们可以减少我们自己做的压力,他们可以自己上去。这是史东杰做的phpHbase,这个是阿帕奇项目的一个Ella.可以看到我们的数据量很大,也是对访问列表的监控,对Hot Regant做的。

Hadoop自己也是大数据的产生者,如何分析Hadoop自己的日志?hunk东西是收费的,我们实现了一个功能,和Hadoop是很类似的。开源的东西是很多等着大家挖掘的,他们其实并不难。我们做的Hadoop的一个共同建设空间项目,会有一个跨省的Hadoop的集群的运维和提交计算任务。

关于开源,我们所有人都是在使用开源的。自己也会把自己写的东西开源出来贡献给大家,同时我们也鼓励更多的人做一个开源的事。程序员真的是可以改变世界的,只要你有一个想法,不管这个想法多大,可以去改变世界。最后是摘自SQLite的一个期盼,希望你行善不为恶,希望你恕技亦恕人,希望你自由地共享,希望你永远不要索取甚于付出。