超融合并非新的概念,它的背后是长期以来,数据中心资源高效利用和低成本运营的驱动。数据中心的传统建设方式是计算、存储、网络、基础软件分层建设,这种方式的优势是各层互相解耦,独立扩展,独立采购方便,存在的问题是规划复杂,在建设之初,就要规划后未来3~5年的业务需求,设计好存算网的配比;运维复杂,需要多支专业的运维队伍(计算、存储、网络、软件);问题定界复杂,一旦出现问题,就涉及跨层的问题定界,异厂商互相推诿。

大约十年前, CI即融合基础设施架构被提出,CI架构主要解决的是融合管理的问题,通过预制的一柜式方案,整合计算、存储和网络资源,进行统一管理,提升基础设施部署和管理的效率,降低OPEX。但是CI架构并没有对硬件资源层做融合,系统性能和TCO都没有大的优化,而且,CI架构为了降低成本,大量使用基于通用服务器的SAN存储,可靠性始终是个问题,因此,CI架构一直没有能成为数据中心的主流架构。更多的被用一些特定负载,如数据库、桌面云等。目前市面上众多的数据库一体机,如天玑、云和恩墨等就是这类CI架构,这类架构计算和存储仍然是解耦部署,如果是强算力场景,就配置高性能的服务器,如果是高可靠场景,就是服务器+高可靠的企业存储底座。有一个很好的比喻,CI架构就像一盘沙拉,看起来像是一道新菜,但是本质上苹果还是苹果、香蕉还是香蕉,没有带来质的飞跃。

随后不久,HCI即超融合架构被提出来,早期的HCI,相对于CI,增加了数据面的软件能力,计算虚拟化负责CPU资源的虚拟化,分布式存储负责对硬盘资源的虚拟化,网络虚拟化负责提供灵活的网络策略,形成一个完整的虚拟化资源池。整体基础设施由于虚拟化软件的使能,实现了资源的池化,提高了资源利用率;同时,不再需要物理的SAN和NAS服务,不再需要配置昂贵的FC交换机,让CAPEX有了大幅下降。此外,HCI在管控面上作文章,让各组件之间更加紧密的集成,提供更高层次的抽象和自动化,更加简化部署和管理,进一步降低OPEX。不管是虚拟化降低CAPEX,还是管理简化,降低OPEX,本质上都是通过软件能力的提升,带来客户价值,这与CI架构简单地进行硬件组合已经不可同日而语。而且,就硬件本身而言,包括Cisco的UIS和HPE的Nimble都开始提供系列化的超融合专用硬件。业界一直有一种声音,认为超融合就是组装服务器,就是换了一个马甲卖服务器,明显是对于超融合架构的一种误读。

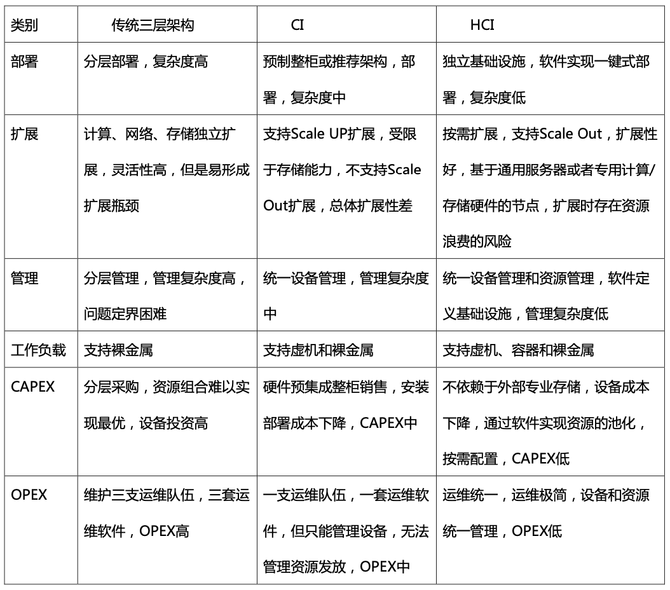

传统架构、CI和HCI架构优劣势对比:

需要看到的是,早期超融合较多的应用于中小型数据中心,其原因在于中小企业对于成本更加敏感,对于CAPEX和OPEX的节省更为在意,另外,中小企业的主流业务负载如VDI、办公OA等的性能和可靠性要求不高,超融合基础设施基本能满足要求。但是,也应注意到,业界主流的超融合厂商也开始进军中大型数据中心,如Nutanix和VxRail,均推出了面向中大型企业的数据中心解决方案。从技术架构上看,超融合包含四个部分,即分布式存储、计算虚拟化、网络虚拟化和运维管理平台。这其中分布式存储和计算虚拟化支持的规模取决与厂商的软件能力,目前主流厂商提供上千节点的支持能力并不鲜见。网络虚拟化即SDN则更是为大型数据中心所生,一般中小型数据中心反而很难应用SDN的能力。唯一的瓶颈在于运维管理平台,对于大型数据中心除了普通的设备管理和日常运维,更重要的是服务提供,这部分能力随着运维管理平台发展成为私有云管理平台也能得到解决。可以说超融合架构服务于中大型数据中心,不是一个技术问题。Gartner在2021年的报告中做出战略预测:到2027年,60%的超融合基础设施将平均分布在中大型数据中心和边缘数据中心,而2021年此比例则不到30%。

预测是美好的,也有诱人的前景。但是我们也应看到,超融合在构建中大型数据中心时仍然存在一些挑战:首先是超融合节点一般选择通用服务器,面向通用负载是够用,但是面向特定负载,尤其是一些关键业务,如OLTP的数据库应用,就显得不足;另外,服务器的存算比是固定的,这样就会出现在数据中心出现能力瓶颈,只需要扩展算力时,存储也随着扩展,只需要扩展存储时,算力也联动扩展,带来了不必要的投资浪费。第二也是最重要的是超融合的存储问题,当前超融合一般是基于分布式块存储,业界很多厂商基于开源Ceph软件来构建分布式存储的能力,安全性、可靠性和扩展性上存在影响,客户不敢在中大型数据中心,关键业务上使用超融合;而且,当前的超融合只支持块存储,但是数据中心的存储越来越多的需求来自于非结构化的文件、对象和大数据存储,这也导致超融合对于一些新的技术应用,如AI、大数据、容器、区块链等支持度不理想。

如何应对这些挑战,成为超融合架构进一步发展必须要面对和回答的课题。

首先,超融合需要多样化的专用硬件匹配多样化场景的差异化诉求。比如最近的热点技术DPU,让超融合通过可组合的方式发挥专用硬件的优势。DPU是数据处理单元,其目标是将CPU从单调且重复的数据处理中解放出来,他是超融合架构中的粘合剂:DPU与盘框的组合,分布式存储的能力卸载到DPU,可实现完全无CPU的存储节点;DPU与CPU结合,卸载虚拟机和大数据处理能力,可以实现完全无盘的计算节点;DPU和DPU之间可以进行数据互访和流动,让每颗CPU都能像访问本地盘一样,访问所需要的数据,消除了原有的跨节点数据瓶颈。VMware的蒙特雷(Monterey)项目和AWS的nitro,都是基于DPU的超融合方案。可以看到,超融合正随着场景的丰富逐步走向多样化的硬件组合以及软硬协同。此外,部分超融合厂商也推出了差异化的专用节点来满足不同场景、不同负载的需求。譬如Cisco推出的HyperFLex系列,定义了四种超融合节点,包括面向单纯计算的UCS系列硬件,和面向存算均衡的混合节点,以及面向高性能场景的全闪存+NVMe的节点,以及面向边缘的节点。又比如HPE推出的Nimble系列,通过支持存算分离的超融合架构允许单独扩展计算节点或者存储节点,用户可根据计算和存储负载强度的不同自定义存算比,兼顾性能、灵活性和经济性。这些都是超融合在多样化专用硬件形态上的实践。

其次,超融合需要安全可靠的专业分布式存储底座,打消用户对于可靠性的顾虑。业界领先的超融合厂商,包括EMC的VxRail和Nutanix,都在专业存储领域具备深厚的积累,只有专业的分布式存储能力才能满足数据中心安全和可靠性的要求,如双活、容灾等能力,解决客户选择超融合的基本担忧;分布式存储可信赖的ScaleOut能力,才能容纳数据中心持续增长的存储需求;专业的分布式存储,在大带宽、低时延和海量文件读写方面的均衡性,才能满足数据中心多样化的的业务应用需求。此外,数据中心的发展,不可避免走向稳态和敏态业务的整合,传统稳态业务,如OLTP数据库和虚拟化,更多的是对分布式块的需求,敏态业务如AI、数据湖等,更多的是对于分布式文件、HDFS和对象的需求,专业分布式存储所提供的协议互通能力,能够很好的应对不同业务的存储需求,实现结构化和非结构数据的共池管理。对于采用开源分布式存储来构建超融合的厂商来说,更需要在存储的可靠性与安全性上持续发力,并且还需要考虑供应商的稳定性和自主可控性。比如近期包括Oracle在内的众多供应商暂停了在部分国家和地区的供应和服务,这对于严重依赖Oracle数据库服务的当地IT机构来说是无法承受的灾难。

最后,回到人类发展的永恒主题——环保。超融合无疑也需要绿色低碳,顺应可持续发展的潮流。这一点,工信部2021年发布的《国家新型数据中心三年行动计划2021-2025》给出了很好的指引:新型数据中心是以支撑经济社会数字转型、智能升级、融合创新为导向,以5G、工业互联网、云计算、人工智能等应用需求为牵引,汇聚多元数据资源、运用绿色低碳技术、具备安全可靠能力、提供高效算力服务、赋能千行百业应用的新型基础设施,具有高技术、高算力、高能效、高安全特征。文件首次从全局的视角来看待数据中心建设,鼓励厂商通过技术创新,在绿色低碳的前提下,提供有竞争力的全栈方案,针对一些特色数据中心场景,如超算中心、智算中心和边缘数据中心,鼓励厂商以整体方案的形式参与。这对于超融合的建设模式是一种利好,也是广大超融合厂商的一个重要机会。

超融合关键在“超越融合”,要实现1+1大于2。从最初实现简单集成的CI架构,到基于管控面和数据面的软件日益强大,形成以软件为中心的HCI架构,再到未来进一步的深度融合:管控面的超融合,要实现计算、存储和网络管理的融合,单数据中心、多数据中心和中心与分支管理的融合,降低客户的OPEX;数据面的超融合,要通过基于专用硬件的软硬协同,实现网存算跨层调度和直通,去除冗余的硬件配置,应对各种负载的性能和可靠性挑战,降低客户的CAPEX投资;存储层的超融合,要通过专业的存储能力,实现结构化和非结构化数据的协议互通,数据流动,消除存储墙,提供安全、可靠和可持续发展的数据底座。超融合在提供客户价值的同时,也在不断地自我超越。