01 介 绍

2020年疫情期间,视频流媒体和会议、在线游戏以及社交网络的需求增长,导致全球互联网流量增长了40%以上,但这并非一个固定的趋势:如今的互联网流量是十年前的15倍。在这方面,数据中心目前约占全球电力消耗的1%-1.5%。其中,高达40%的能耗来自冷却系统,这充分表明开发新的可持续解决方案的必要性。

与传统的空气冷却系统相比,液体冷却具有诸多优势,例如更高的热容量和更低的运输能耗。液体冷却技术用于服务器冷却的有效性已通过浸入式和间接冷板(也称为直接芯片冷却)系统得到广泛验证。使用带有冷板的间接单相液体冷却可以提高冷却液温度并将废热重新用于其他用途,从而进一步提高数据中心的效率。

液体冷却具有比空气冷却更高的传热能力,为解决数据中心的热管理挑战提供了一种颇具前景的途径。该技术利用液体卓越的吸热特性,有望显著降低能耗,缓解冷却相关的瓶颈问题,并为数据中心更可持续的未来运营铺平道路。然而,液体冷却的采用也带来了一系列技术、经济和物流方面的考量,必须彻底探讨这些因素,才能确保成功实施。

本研究描述了在真实数据中心实施的一项中试测试,以测试由Universal Smart Cooling SL (UniSCool) ,开发的直接芯片液体冷却系统。将特定CPU温度限制下的能耗结果与现有风冷系统的能耗结果进行了比较。

02 用于直接芯片液体冷却的冷板原型

该设计和制造的冷却装置将用于戴尔PowerEdge R740服务器的直接芯片液体制冷。该型号服务器包含两个英特尔至强金牌6130处理器,每个处理器的热设计功率(TDP)为125W,最高机箱温度为87°C。TDP表示组件在高负载情况下预计产生的最大热量。CPU集成散热器(IHS)的尺寸为70x47mm²,即散热器或其他散热解决方案与CPU或GPU处理器接触的表面。

本研究设计了分配器的几何形状,并根据该试点项目的CFD模拟对所选技术进行了测试。下文将解释所用冷板的几何形状以及试点项目所采用的分配器的设计。

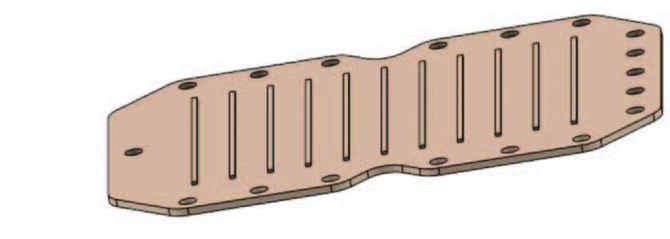

图1.带有入口(蓝色箭头)和出口(红色箭头)水流的直接芯片冷却系统的3D示意图。

UniSCool研发的冷却装置由分配器和铜基座组成(图1),铜基座上设有水流通道,用于冷却CPU。分配器和铜基座用螺钉固定,并在两部分之间放置O形圈以防止泄漏。分配器的厚度根据制造的铜件的曲率和服务器的可用空间进行了调整。

A.铜冷板设计与制造

UniSCool冷板采用铜制成,因为铜具有较高的导热系数(κCu=385W/mK)。铜冷板由舍布鲁克大学采用铣削技术制造。该设计基于10个通道,每个通道宽度为6毫米,高度为0.5毫米,长度为47毫米(图2)。通道的宽度允许在通道之间集成UniSCool专利散热片,但这方面超出了本研究的范围。

图2.为当前PoC设计和制造的Cooper冷板。

B.流体分配器设计与制造

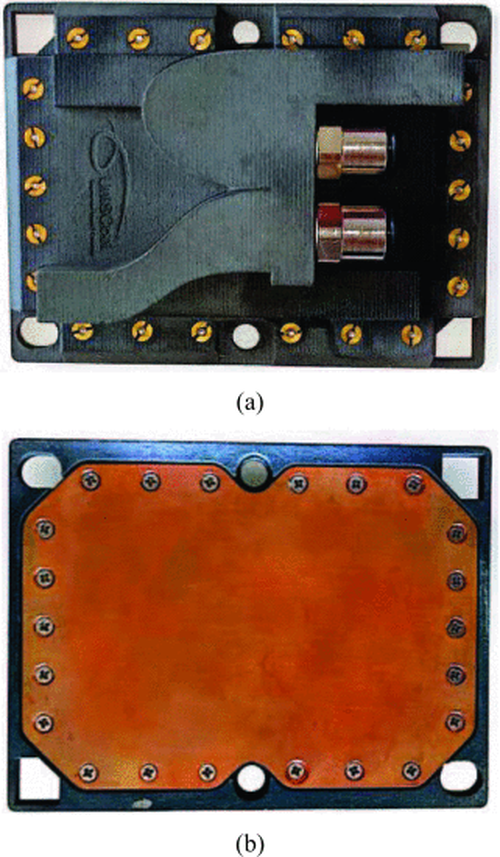

分配器的底座与戴尔PowerEdge R740服务器中使用的散热器尺寸相同,以方便新设备的安装(图3)。

流体分配器的设计目的是在封装设计的同时,从顶部表面为冷却板供液。其尺寸经过调整,以适应服务器现有的散热器,并使用相同的支架将其固定到CPU上。它采用3D绘图程序进行设计,并使用3D树脂打印机制造(图3)。这种3D打印技术可以实现防水部件,这对于液冷系统至关重要。这是传统丝材打印所不具备的特性。

分配器经过平衡设计,确保所有通道的流量均等。管道通过3/8英寸的配件连接到分配器。因此,分配器设计有相应的螺纹。

用于下述测试的收集器已通过泄漏测试进行测试,测试方式是将收集器浸入水中,并在测试过程中引入高于工作条件的压力空气。

图3.UniSCool设计和制造的直接芯片液体冷却系统的顶视图(a)和底视图(b)的图像。

03 方法论

A.冷却分配单元和散热单元

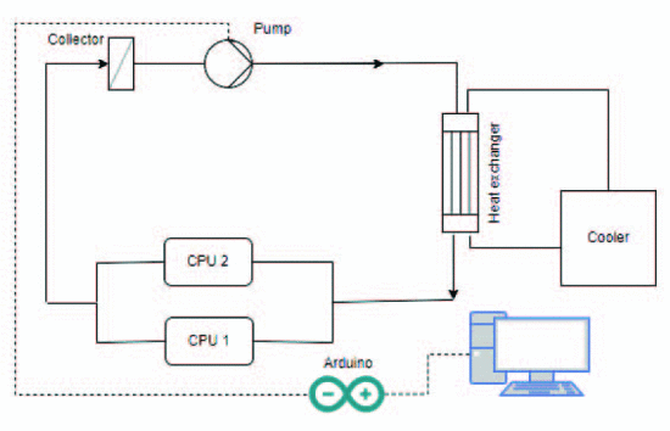

在本研究中,设计了一个液压回路来评估所开发的直接芯片液体冷却技术在真实数据中心条件下的性能(图4)。该回路准确地模拟了运行环境,从而可以全面评估冷却效率以及在实时数据中心运营中实施该技术的实际可行性。设计和制造了一个冷却分配单元(CDU)来封装整个冷却系统,并包含正常回路运行所需的主要元件。这些元件包括一个离心泵,其尺寸可以克服回路的压降并提供足够的流量以将CPU保持在80°C以下;一个液-液(L2L)热交换器,负责在水从入口流向出口时冷却冷板;以及一个集水器,用作气泡提取器。二次水回路在冷却器和L2L热交换器之间循环,以确保入口温度恒定在25°C,从而实现有效的散热。该电路使用Arduino进行操作,它充当数据采集设备并调节泵送功率以维持CPU的更优温度。

图4.设计的液压系统示意图。

B.测试程序

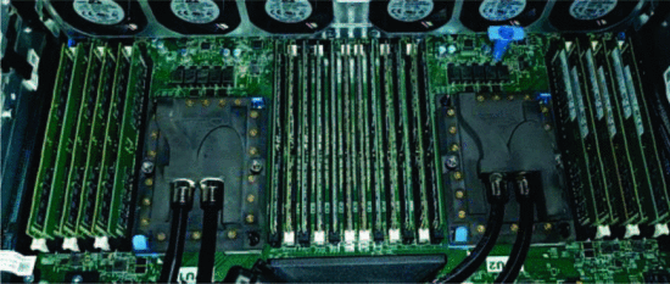

本节概述了对前文所述设备进行的测试程序。主要目标是评估UniSCool设备的可靠性和效率,并将其性能与数据中心目前使用的传统空气冷却系统进行比较。首先,UniSCool直接芯片液冷系统已成功安装,用于冷却Dell EMC PowerEdge R740服务器的CPU(图5)。随后,在实验室中验证了整个电路,以确保其功能正常,并识别和纠正任何潜在的泄漏。随后,配备UniSCool冷却系统的服务器被安装在巴塞罗那数据中心的机架中。CDU也安装在机架内部,恒温槽则放置在附近。在这种环境下,UniSCool系统的可靠性得到了验证,并将其性能与传统风冷系统进行了直接比较。

图5.安装在Dell Power Edge R740服务器中的直接芯片UniSCool液体冷却系统的图像。

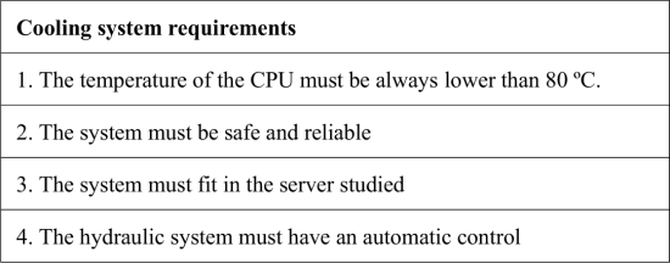

测试旨在确认系统满足表1中描述的要求。

表I.直接芯片液体冷却系统需满足的要求列表。

为了评估定义的冷却要求,电路连续运行4天,以评估其长期性能和可靠性。随后,进行了一系列测试,以评估服务器在各种负载场景(25%、50%、75%和100%)下对CPU施加10分钟的散热和能耗行为。测试程序从现有的风冷系统开始。此阶段的重点是测量CPU温度、风扇功耗以及服务器整体功耗,这些数据均由戴尔的iDrac软件记录。由于此阶段的主要目标是评估能耗而非散热性能,因此本次测试未评估风冷系统的散热性能。

随后,我们将传统的风冷系统替换为UniSCool液冷系统。采用相同的负载场景,并将冷却系统配置为将CPU最高结温维持在80°C。在这些测试中,还测量了水泵的功耗,以评估已安装液冷系统的整体效率。

04 结 果

该系统连续运行4天,没有任何问题,证明了其可靠性和稳健性。此次不间断运行验证了后续测试,表明该系统能够长期保持一致的性能,并且没有泄漏或断开等可靠性问题。

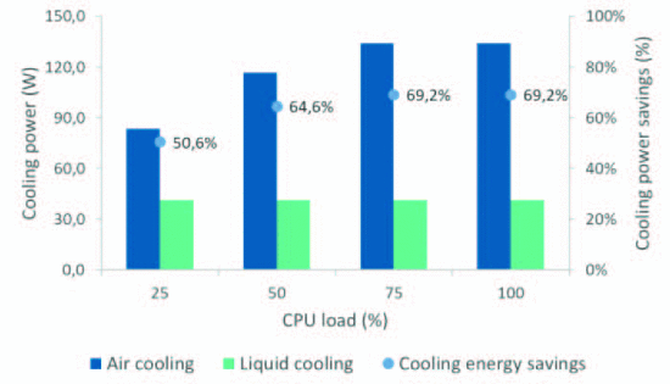

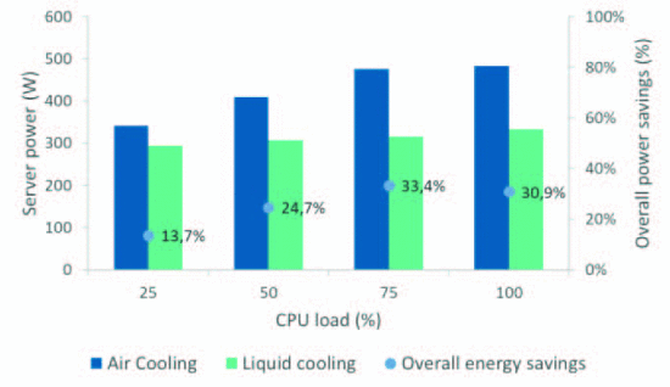

在测试阶段,UniSCool液冷系统实现了显著的冷却节能效果,根据施加的负载,节能效果在50%到69%之间(图6)。此外,在使用液冷系统时,我们观察到CPU过度冷却,因为其最高温度始终保持在50°C左右。这种冷却水平表明系统在运行过程中具有显著的热性能裕度,这意味着可以在不影响冷却效果的情况下进一步降低泵送功率。此外,在评估服务器的整体能耗时,开发的UniSCool液冷系统可节省13%至30%的能耗(图7)。该计算仅基于服务器的功耗,不包括数据中心空调系统或维持入口液体温度所需的恒温槽所使用的能耗。

如果与自然冷却系统相结合,UniSCool液体冷却系统的效率可以进一步提升。自然冷却系统利用周围环境条件来减少对机械冷却的需求,从而为数据中心空调节省更多能源。将UniSCool直接芯片冷却解决方案与此类系统集成,可以打造更节能的冷却解决方案,显著降低运营成本和总体能耗。

图6.测试服务器采用风冷和直接芯片液冷技术的冷却能耗,以及与风冷解决方案相比,使用UniSCool液冷带来的节能效果。

图7.采用空气冷却和直接芯片液体冷却技术的服务器整体功耗,与空气冷却解决方案相比,由于液体冷却而实现了能耗降低。

05 结 论

这项研究成功证明了在实际运行条件下数据中心内直接芯片液体冷却系统的安装和验证。

该系统经过了可靠性和安全性测试,结果令人满意,并确认所开发的液冷系统可以连续运行长达四天而不会出现问题。此外,与传统的风冷系统相比,液冷系统实现了显著的节能效果。具体而言,根据施加的热负荷,该冷却系统可实现50%至69%的节能效果。在CPU负载最高(75%和100%)时,冷却节能效果最为显著。

此外,据观察,当前的液冷系统在运行时冷却能力过强,导致CPU温度低于正常水平。这种过度冷却现象表明,仍有潜力进一步优化冷却系统,使CPU温度更接近制造商建议的更优温度(80°C左右)。液冷系统对服务器整体功耗的影响显著。冷却风扇所需功率减少了一半,液冷系统可节省服务器总功耗的13%至30%。这一降幅凸显了通过消除或缩小风扇系统尺寸来进一步降低服务器总功耗的潜力。虽然本研究量化了液冷系统实现的节能效果,但仍有进一步改进的潜力。具体而言,将液冷系统集成到现有的制冷基础设施中可以降低能耗。维持稳定的25°C水温所需的能耗远低于风冷,这意味着整体能耗可以进一步降低。

总而言之,这项概念验证研究证实,直接芯片液冷系统在数据中心实施时可显著节省能源。结果表明,液冷成为服务器环境中的标准技术,取代传统的风冷系统,可能只是时间问题。