随着网络的发展,每天有海量的UGC视频被用户上传到各大平台,如何高效的分发与使用这些视频是平台一直需要解决的问题。

视频的标签可以高效概括视频的主体内容,有利于推荐、搜索广告等业务对于海量短视频的精确使用。标签的生成是视频理解的产物,按照类型来分,可以分为类型标签和内容标签。类型标签主要是根据各业务的特点定制一套体系框架,将每个短视频映射到定制的框架中。而内容标签是用于描述视频主体内容的开放式词汇集,很难提前制定完备的体系枚举出每个词汇,更多的时候它是一个无穷的集合。本文详细介绍爱奇艺短视频场景下的内容标签。

01

背景

标签依赖多模态元信息

标签的生成依赖视频的原始信息。短视频的元信息主要包括标题,简介描述,上传者资料,视频影像,音频等各种模态信息。我们要求算法能充分融合利用各类信息,从多个不同的侧面去刻画短视频信息,可以避免单维度缺失导致精度识别的不稳定性的问题。

多模态元信息包括音视频、标题、简介、上传者等

标签生成的难点

标签作为描述内容的词汇集,并没有客观的评定标准。不同业务因为业务关注点差异,有不同的标注规范。即便同一个业务有统一标注体系,但很多case不同的标注人员有不同的理解。

很多标签是对内容的抽象概况,需要算法真正理解视频的内容并予以总结。比如短视频【买鸡蛋,选大的好还是选小的好?养殖户说漏了嘴,以后别瞎买了】,其标签规范为“生活”,“鸡蛋”,“小窍门”。其中“小窍门”就是需要结合视频内容进行提炼的。再比如大部分人物闲聊类属于生活类目,但如果视频对于生活的某些方面做了总结,对于其他观看的人群有一定的借鉴作用,可能就会属于百科类目。

对未见过的新内容的理解。比如对于新上线的电视剧片段【赘婿】,希望有自动化打上“赘婿”、“郭麒麟”这样标签的能力。

标注规范的不断变更。比如某些活动类的标签,“暑期玩具大放送”、“美食达人成长计划”都是固定时期开展的短视频类活动,有一定的时效性。再比如影视剧集类的视频随着业务的深入,对于人物角色识别要求逐步增强等。

02

模型整体框架

短视频标签整体框架

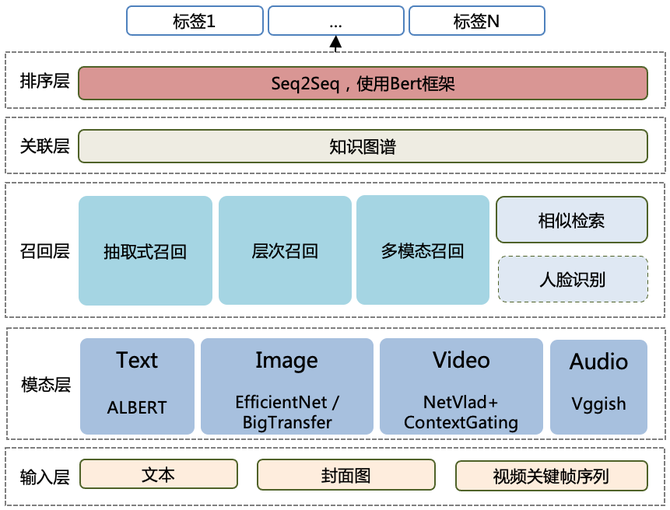

整体方案上,短视频标签模型以短视频多模态元信息为输入,先经过多种预训练模型的特征提取,之后融合了多种不同的召回模型:包括基于文本的抽取式模型,基于优质标签类目的分类模型,融合多模态信息的生成式模型。此外还使用了相似短视频检索、人脸识别等方法,扩充了可利用的标签词汇,从不同的视角生成异质的短视频标签。最后经过排序模型,对各召回源的标签进行置信度打分,最终根据业务侧的打标倾向和准召要求,为每个业务线裁剪出最终的短视频标签集合。

模态层

一、文本模型

近些年基于预训练的模型对于少样本、信息量少的场景有很好的增益作用。爱奇艺作为中国领先的视频内容平台,涵盖非常多的业务场景,我们训练了更适配具体业务场景的预训练 ALBERT 模型。具体来说,预训练模型在站内海量的短视频上进行预训练后,再根据特定场景进行 Finetune 。预训练过程包含两个不同的预训练任务,分别是 Masked Language Model 和 Sentence-order prediction 任务。SOP 任务通常是在长篇幅文本中随机的交换的句子,由于短视频中存在的标题、描述、评论等文本通常都较短,我们改造 SOP 任务为更短的子句或短语粒度的交换任务。

二、图像模型

基于图像表征的模型,比较常用的有 ResNet50 、 Inception V3 、 Xception 、 EfficientNet 、 BigTransfer 等。

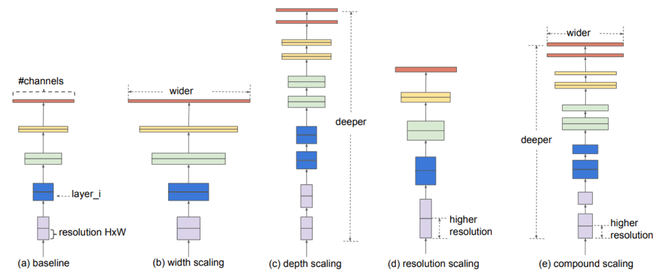

图像模型,目前通用的几种方法是放大 CNN 的深度、宽度和分辨率,之前都是单独放大这三个维度中的一个,但是这三个维度如果结合在一起进行缩放,会达到更优化的性能,但是如果放大过多会影响模型的效率。EfficientNet 提出了一个新的复合缩放方法—使用一个复合系数统一缩放网络宽度、深度和分辨率,在 base 网络上学习好这三个维度的缩放参数,再同比进行放大学习即可。模型参数的缩放对比如下图所示:

三、音视频模型

融合音频与视频的维度特征,当前使用的是 MixNeXtVLAD 模型,该模型由 NetVLAD 、NeXtVLAD 一步步的演变而来。

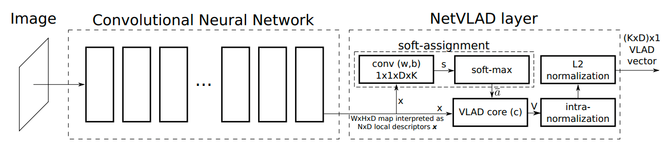

NetVLAD 是 frame-level feature 融合为 video-level feature 的一种方法。从视频帧聚类的角度学习视频的 embedding 表示,类似于视觉词袋模型,但是相比词袋模型多了与聚类中心的距离和方向信息,而且聚类中心是自动学习出来的。整体算法结构如下:

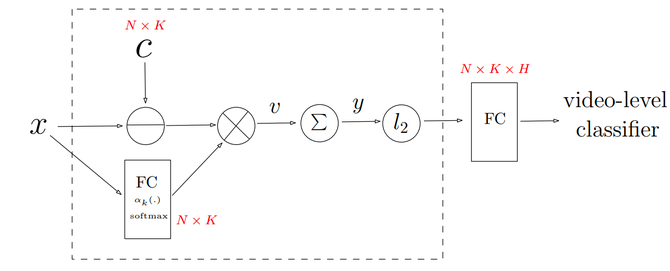

NeXtVLAD 在 NetVLAD 的基础上引入了分组的概念,降低参数,增强模型的泛化性能。

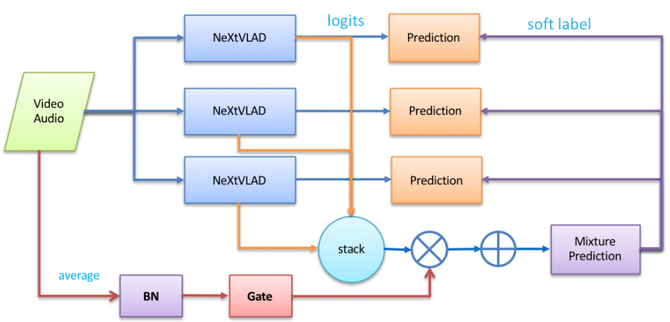

MixNeXtVLAD 是 NeXtVLAD 的进一步升级,采用了多个 NeXtVLAD 的Student branches ,并且利用了知识蒸馏的思想,将三个 Student 网络的单个输出加权融合的结果作为 Soft Labels 反过来指导每一个 Student 网络的学习,多个模态的 NeXtVLAD 聚合输出通过 SE-Context Gating 学习多模态特征交叉,增强特征表示能力,Mixture prediction 是每个 Student 输出的加权和,最后取 Mixture prediction 为网络的最终输出。整体框架如下:

模型的输入包含两个部分:视频特征与音频特征。视频特征主要对视频进行多种方式的抽帧,对抽帧结果通过图像模型进行进行解析,得到视频的特征。音频特征通过 VGGish 抽取得到。

音视频模型框架

召回层

一、多模态融合召回

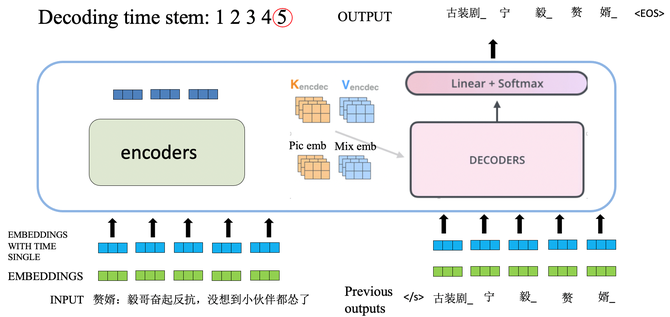

为达到标签生成的目的,可以将标签融合看做是机器翻译任务,输入的源语言为短视频相关的文本以及对应的图像及音视频表示。目标语言为最终需要的标签。这里用到的主要模块为 Transformer ,其具有很强的语义编码能力,主要分为编码和解码两个部分。Encode 端将多模态元信息作为输入进行编码。Decode 阶段,将编码后的文本表示,图像表示,音视频表示和上一时刻的输入作为输入进行解码。最终的结果为多模态融合后生成的标签。整体框架如下图:

二、抽取式召回

有些标签可以从文本中直接得到,故引入抽取式召回直接从文本中抽取相关标签。抽取式召回采用 Bert-BiLSTM-CRF 模型,用 Bert 模型学习词嵌入embedding ,再通过 BiLSTM-CRF 进行实体识别的过程。这是业界较为成熟的框架,不再赘述。

三、层级召回

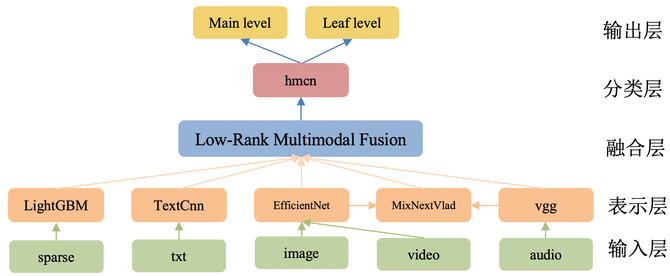

为了保障主标签和优质标签的覆盖,我们也构建了标签分类体系:包括约 3000 个优质标签的层次结构,使用 Dense-HMCN(Hierarchical Multi-Label Classification Networks)模型进行层级分类。整体框架主要分为特征表示、特征融合和层级分类三个模块,前两个模块基于多模态特征建模短视频的高阶表达,后者基于构建的表达完成分类。模型的输入与多模态融合召回模型类似,包含视频的各个维度的语义特征,并增加了一组基于LightGBM构造的稀疏特征。和多模态融合召回不同,层级召回更侧重准确率,保障优质标签的质量。

四、其他

为了进一步增强标签的召回率,我们也引入了人脸识别、相似同类视频标签检索等方法。此外,在召回之后,我们利用知识图谱的关联和推理能力,根据业务线的打标需求,对召回的标签进行进一步的扩展和推理:例如召回”赘婿“、”宁毅“后,可进一步召回”郭麒麟“的标签。由于篇幅关系,不再赘述。

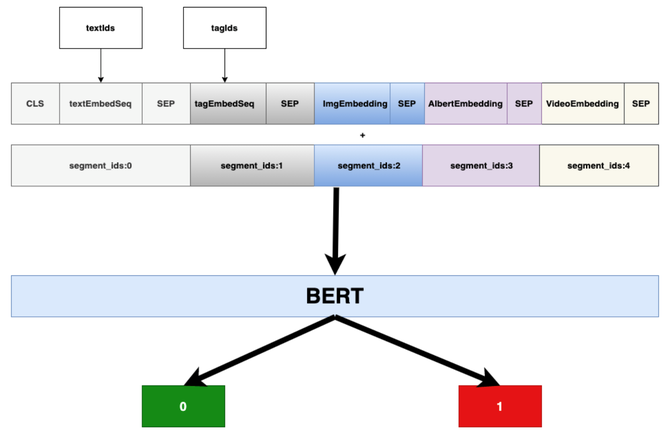

排序层

排序引入 bert 模型框架做基于多模态的融合打分,模型的输入为各召回源的标签、权重以及各模态的特征表示,特征融合方式同时采用 early fusion 和 late fusion 机制:early fusion 是将不同模态特征作为不同的 sentence 输入到 bert 模型中;late fusion 机制则将召回源和权重与【CLS】进行融合。依托框架的特性,不同模态特征之间可以进行有效的交叉融合,更好适配标签业务场景。最终模型赋予每个标签一个排序得分。模型结构如下图:

03

标签的应用价值

短视频标签的智能化应用对于爱奇艺视频业务提供了可靠保障。典型的应用场景为视频生产、个性化推荐、智能运营等。比如,传统视频生产的时候,需要编辑或生产者基于人工理解对视频打上元信息。标签系统可以在人工打标时提供候选,提高人效。又如,个性化推荐就是要将用户的兴趣与内容进行匹配,标签是对视频的精细化表达,可以帮助推荐系统更精准地给用户推送感兴趣的内容。另外,专属的地域标签等,可以辅助运营对内容进行智能分发,类似资讯新闻等可以瞄准当地进行传播。

随着越来越多海量娱乐内容的出现和各种多模态技术的发展,智能化自动化的内容理解能力越来越成为视频行业的趋势和标配。我们将继续探索如何进行更好地落地,并在产品上衍生出更多的技术应用。