两个月前,在NVIDIA GTC 2021峰会上,NVIDIA正式发布了新一代数据处理器NVIDIA BlueField-3 DPU,为数据中心提供强大的软件定义网络、存储和网络安全加速功能。

两个月后,笔者有幸采访到了NVIDIA网络事业部亚太区市场开发高级总监宋庆春和UCloud资深技术专家马彦青,听两位跟我们分享了NVIDIA DOCA是如何实现从BlueField-3芯片级数据中心到三U一体超大规模数据中心的统一架构,以及UCloud基于NVIDIA DOCA生态的技术实践。

为什么NVIDIA要推出DPU?

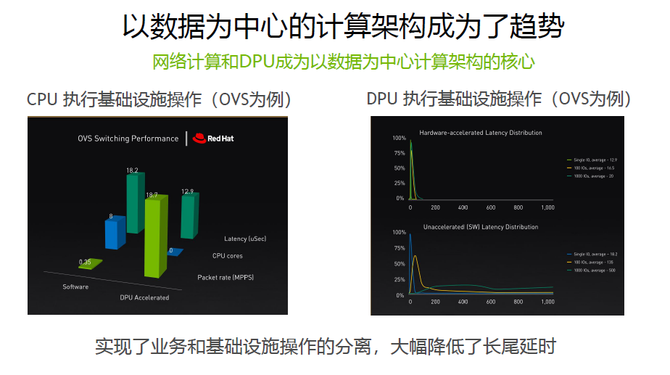

随着AI技术的普及和数据量爆发性增长,数据中心正在发生变革。从传统的冯·诺依曼架构的数据中心转向以数据为中心的架构,数据在网络通信过程中,很多通信模型会制约整个系统性能的发展,这就给我们提出了一个新的挑战--如何继续提升数据中心性能。

网络计算以数据为中心的新的架构,帮我们解决了这个问题。以数据为中心的新的架构,意味着数据在哪里,计算就在那里;当数据在GPU上,计算就在GPU上;当数据在CPU上,计算就在CPU上;当数据在网络中传输的时候,计算就在网络中。

通过这样的方式就可以解决网络传输中多打一的瓶颈问题或丢包问题。新的架构可以使通信延时降低10倍以上。所以,网络计算成为我们现在以数据为中心这种核心计算架构的关键技术之一。

NVIDIA网络事业部亚太区市场开发高级总监宋庆春表示:“DPU的出现为以数据为中心的计算架构提供了非常创新的思路。以OVS操作为例,当我们run OVS在CPU上,会消耗很多CPU的核,但运行OVS的效率非常低,如果要把OVS操作放在DPU上可以把这个包转发率大幅度提升,而把CPU利用率大大地降低。”

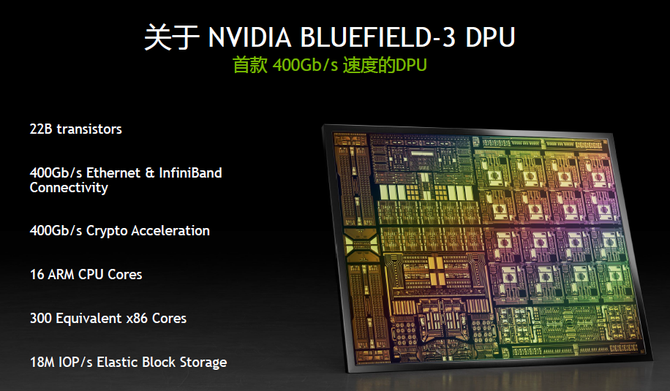

BlueField-3构建下一代安全数据中心计算单元

据宋庆春介绍,BlueField-3是业界第一款400G速度的DPU。在BlueField-3上,我们会出400G的Ethernet或者InfiniBand的接口。值得一提的是,在BlueField-3上可以来实现400Gb/s加解密的速度,不管是用IPSec还是用TLS,在加解密的速度上都可以达到400Gb/s的全线速。

不仅如此,BlueField-3还集成16个ARM CPU的核,它有更powerful的处理器。从它整个Offload(卸载)功能来看,一个BlueField-3的DPU可以实现的offload功能可以相当于300个X86CPU的核,这样我们原来需要很多CPU的核来做的操作,通过用DPU专业的offload engine,可以轻松地在DPU上面来实现,从而把这么多的CPU核offload出来,还给业务。

在存储上可以实现18个million的IOP/s。现在存储如果能达到1个million的IOP/s已经是非常高的性能,但在BlueField-3上,可以在不消耗主机CPU的情况下而达到18million的IOP/s。

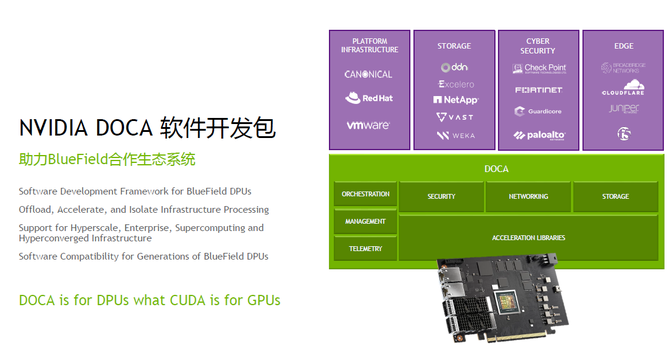

DOCA实现从单芯片到超大规模的数据中心统一架构

据了解,DOCA软件开发包是专门为DPU开发的软件包。它的价值就像CUDA对GPU一样,通过CUDA可以看到所有GPU的开发接口,可以对它做编程。

DOCA也是如此,DOCA上各种业务,不管存储还是安全,以及其他与用户有关的业务都可以通过DOCA界面调用DPU里Offload的Engine,安全、网络、存储以及Orchestration,来对它进行编程。从DOCA的Vision来看,是想提供通过软件定义把所有的硬件加速的engine都调用起来的Infrastructure服务。

不仅如此,我们还可以通过DOCA来实现软件定义网络,可以通过DOCA来实现软件定义存储,通过DOCA来实现软件定义安全,无论是存储、安全和网络,你都可以通过DOCA和BlueField硬件关联起来,直接调用到硬件的加速引擎。

从DOCA软件栈来看,DOCA软件栈主要有两层:一是DOCA的driver和runtime,二是DOCA的Library,DOCA library主要是针对业务提供接口,在driver和runtime上,主要是怎么样调用硬件加速engine,怎么样将硬件的加速engine提供给上层的通信库。

从DPU生态系统来看,已经得到了不管是操作系统厂商还是做应用的厂商,还是做安全、存储各个厂商的广泛支持。

UCloud基于DPU构建下一代软件定义数据中心基础架构

近年来,云主机因其弹性、易用、低成本优势逐渐成为企业部署业务的首选,但有些对业务性能要求极高的企业依然会选择使用独享的物理机。传统的物理机固然具备天然的高性能和强隔离特性,实际上却由于部署流程冗长、灵活扩展性较差而难以满足企业高速发展的业务需求。为此,UCloud的裸金属物理云2.0就很好的解决了上述问题,其兼具物理机的高性能与虚拟机的弹性。

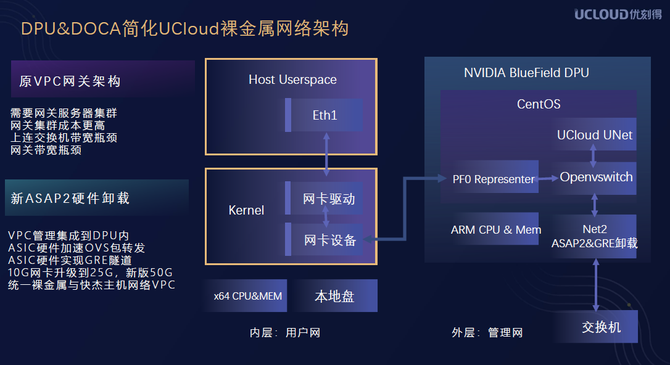

据UCloud资深技术专家马彦青介绍,我们基于DPU&DOCA做的网络卸载。

我们原先的网络架构使用的是VPC网关,作为裸金属服务器的VPC之间划分的方法,这种方法会使用很多的网关服务器集群来进行管理,而这个集群服务器本身就面临着一个成本,大概4-8台一个小集群,当跨网关的时候会存在带宽的瓶颈。

我们将原来的10G网卡提升到现在DPU25G之后,它的性能也大大提高,在我们裸金属2.0产品里,做了双网卡的bonding之后,带宽可以提高到50G。这样在裸金属网络架构里使用了DPU之后,就可以和快杰云主机网络使用相同的VPC管理方式,而且双方之间可以进行直接互通,也提高了它的连接效率。

不仅如此,UCloud还利用DPU和DOCA重构了UCloud裸金属存储架构。使用NVIDIA BlueField DPU提供的NVMe SNAP功能,将UCloud的云存储产品RSSD呈现为本地的NVMe系统盘和数据盘,为物理云客户提供了更灵活易用的云盘存储服务,并且,UCloud的RSSD云盘使用BlueField DPU成熟的RDMA能力,性能也达到了非常高的水平,真正实现了灵活性与性能的兼顾。

马彦青表示:“双方在裸金属物理云的基础上进一步探索虚拟化应用场景,DPI深度包检测以及Micro Segmentation等应用场景,非常期待双方的持续合作为市场带来充满创新和有价值的云产品。”

写在最后,随着网络计算和DPU的崛起,数据中心成为了新的计算单元。从计算到网络,从GPU到CPU和DPU,英伟达构建的“AI帝国”已经初步完成。谁掌握了计算和数据,谁就掌握了未来。在这条道路上,英伟达已经先走一步。