【IT168 资讯】在本周举行的Hot Chips大会上,英特尔将挡在Knights Mill前的帷幕小小地拉起了几分——Knights Mill是英特尔针对机器学习应用而研发的一款Xeon Phi处理器。

作为英特尔在AI领域多管齐下的一部分,“Knights Mill”代表了该芯片制造商的第一个专门针对机器学习市场,专门用于训练深层神经网络的Xeon Phi产品。在深度学习推论方面,英特尔推出了其基于Altera的FPGA产品,微软在其Azure云(对人工智能和网络加速)中大量使用了该产品。英特尔还在开发其他机器学习产品,用于训练工作,这些产品将来自公司去年收购的Nervana公司。

与此同时,Knights Mill将用来填补目前Knights Landing处理器——用于HPC的Xeon Phi芯片——和未来的基于Nervana的产品之间的空白。在这种情况下,Knights Mill将从Knights Landing中继承大部分的设计,最明显的改变是硅的数量,致力于获得更精确的数学性,最适合于神经网络的运算。

从本质上讲,Knights Mill用一个较小的双精度端口和四个向量神经网络指令(VNNI)端口,取代了Knights Landing的矢量处理单元(VPU)上的两个大的双精度/单精度浮点(64位/ 32位)端口。后者支持单精度浮点和混合精度整数(16位输入/ 32位输出)。因此,它看起来像是张量处理单元(TPU)的英特尔版,它在NVIDIA的新V100 GPU的张量核心中有对应物。不过,后者仍然是更传统的16 / 32位浮点运算。

最终的结果是,与Knights Landing相比,Knights Mill将提供一半的双精度浮点性能,两倍的单精度浮点性能。在VPU(256 ops/cycle)中添加了VNNI整数支持,英特尔声称Knights Mill将提供4倍于深度学习应用的性能。

使用整数单元来增强深度学习性能的方法有些不太传统,因为大多数应用程序都使用浮点运算。然而,英特尔坚持认为,浮点数在准确性方面几乎没有优势,而且在计算上更昂贵。这种权衡是否成功还有待观察。

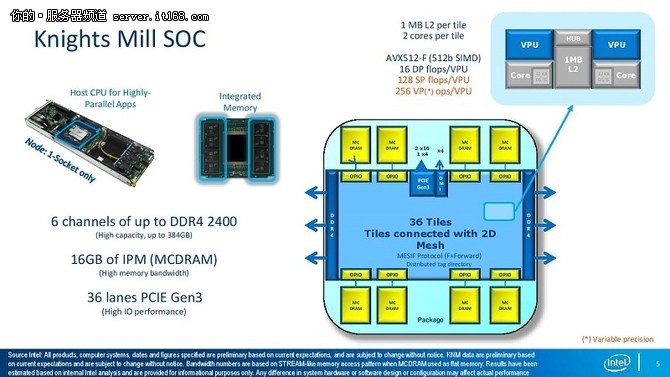

Knights Mill还将支持16 GB的MCDRAM——组装在一个3D堆栈中的英特尔版on - package高带宽内存——以及6个DDR4内存通道。从他们在Hot Chips(上图)公布的图表上看,这个设计似乎支持72核,至少对于这个特殊的配置而言是这样。为VPU提供256个ops / cycle值,这意味着Knights Mill可以交付——以1.5 GHz处理器来说——超过27万亿次的深度学习性能。

实际性能是多少,我们会在英特尔开始生产该产品之后得知。据悉,Knights Mill计划于今年第四个季度推出。