每年的GTC大会都是NVIDIA秀肌肉的时刻,这次也不例外。除了全新的CPU产品以及NVIDIA Hopper架构,NVIDIA的产品布局更加全面,涵盖了基础设施的方方面面。在软硬件加持下,NVIDIA的“以工业规模创造智能,并将其融入真实和虚拟世界。”愿景正在加速到来。

又是一年GTC大会,那么,NVIDIA在网络产品技术领域给我们带来了哪些惊喜呢?

NVIDIA Spectrum-4:不只是一个网络平台

我们知道,NVIDIA提出了3U一体的数据中心加速计算架构,即GPU解决并行计算的工作负载,DPU承担加速数据移动的工作负载,CPU承担通用计算业务应用的工作负载,但在3U一体的数据中心架构中,网络平台在其中起到了互连互通的关键作用。因此,NVIDIA创新性的发布了NVIDIA Spectrum-4新一代以太网平台,为大规模数据中心基础设施提供所需的超高网络性能和强大安全性。

NVIDIA网络专家 崔岩

据NVIDIA网络专家崔岩介绍,Spectrum-4以太网平台不光是一款交换机产品,它是由三大部分构成:Spectrum-4交换机,加速整个云网络架构;ConnectX-7智能网卡,加速服务器节点中网络性能适配器;BlueField-3 DPU,可编程数据中心基础架构;这三大组合部分共同搭建了端到端的400G超大规模网络平台——Spectrum-4。

那么,它有哪些过人之处呢?据了解,作为全球首个400Gbps端到端以太网网络平台,NVIDIA Spectrum-4的交换吞吐量比前几代产品高出4倍,达到51.2Tbps,能够大幅加速大规模云原生应用。

在NVIDIA Spectrum-4交换机性能与创新方面,NVIDIA Spectrum-4 ASIC和SN5000交换机系列基于4N工艺,包含1000多亿个晶体管以及经过简化的收发器设计,具有领先的能效和总拥有成本。凭借支持128个400GbE端口的51.2Tbps聚合ASIC带宽,以及自适应路由选择和增强拥塞控制机制,Spectrum-4优化了基于融合以太网的RDMA网络架构,并显著提升了数据中心的应用速度。

凭借12.8Tbp加密带宽和这些安全功能,Spectrum-4将成为市场上优秀的、高性能的、安全的端到端以太网网络平台。由Spectrum交换机、BlueField DPU和ConnectX智能网卡组成的Spectrum平台能够提高AI应用、数字孪生和云基础架构的性能和可扩展性,为现代数据中心带来极高的效率和可用性。

如今,数据中心呈现指数级增长,应用层面、服务器层面对网络带宽的要求越来越高,同时还要提供更好的安全性和强大的功能。所以,为了满足这些需求,要提供一个可以在大规模应用场景下又能提供高性能、低延时,还可以提供高级的虚拟化和模拟仿真支持的以太网平台,是一个必不可少的解决方案。

崔岩表示,Spectrum-4不只是一个网络平台,我们会将其和NVIDIA其他的平台软件和应用做整合,这样可以达到最好的网络应用效果。同时,我们还有Cumulus Linux网络操作系统、SONiC网络操作系统、DOCA的开发平台开发套件。通过DOCA可以更好的在 BlueField DPU上面做软件开发,在大规模云原生应用场景下加速整个数据中心,基于基础设施的虚拟化和软件定义、硬件加速的网络、存储、安全来提供更多的应用和服务。

NVIDIA OVX、H100 GPU、H100 CNX、DGX H100一个都不能少

为了更好地推动NVIDIA Omniverse的落地,NVIDIA发布用于驱动大规模数字孪生的NVIDIA OVX计算系统。

NVIDIA网络市场总监 孟庆

据NVIDIA网络市场总监孟庆介绍,OVX服务器由8个NVIDIA A40 GPU、3个NVIDIA ConnectX-6 Dx 200Gbps网卡、1TB系统内存和16TB NVMe存储组成。OVX计算系统可以从由8台OVX服务器组成的单集群扩展到通过NVIDIA Spectrum-3交换架构连接的一个或多个OVX SuperPOD(由32台OVX服务器组成),来加速大规模数字孪生模拟。

谈到OVX就不得不说说H100 GPU,从技术进展来看,H100采用台积电4N工艺、台积电CoWoS 2.5D封装,有800亿个晶体管,搭载了HBM3显存,可实现近5TB/s的外部互联带宽。与此同时,H100还是首款支持PCIe 5.0的GPU,也是首款采用HBM3标准的GPU,单个H100可支持40Tb/s的IO带宽,实现3TB/s的显存带宽。

为了加速大型AI模型,NVLink结合全新外接NVLink Switch,可将NVLink扩展为服务器间的互连网络,最多连接多达256个H100 GPU,相较于上一代采用英伟达NVLink只能在DGX机器内连接8个GPU,能力扩大了32倍。

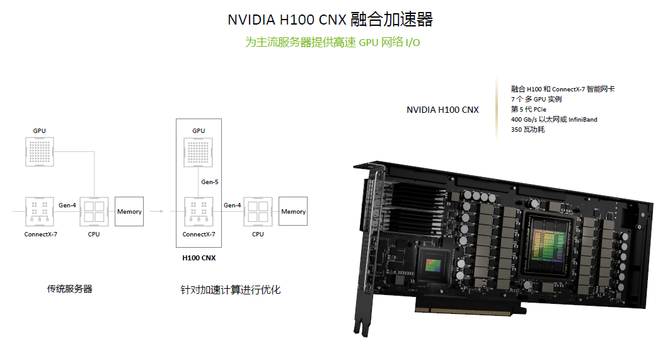

据了解,NVIDIA为了将Hopper GPU的强大算力引入主流服务器,还推出了全新的融合加速器H100 CNX。它将网络与GPU直接相连,耦合H100 GPU与英伟达ConnectX-7 400Gb/s InfiniBand和以太网智能网卡,使网络数据通过DMA以50GB/s的速度直接传输到H100,能够避免带宽瓶颈,为I/O密集型应用提供更强劲的性能。

DGX H100系统是新一代英伟达DGX POD和DGX SuperPOD超级计算机的构建模块。借助NVLink Switch系统,拥有32个节点、256个GPU的DGX Pod,其HBM3显存达20.5TB,显存带宽高达768TB/s。通过采用Quantum-2 InfiniBand连接及NVLink Switch系统,新DGX SuperPOD架构在GPU之间移动数据的带宽高达70TB/s,比上一代高11倍。

写在最后,这些年来,NVIDIA GTC大会已经成为一场面向AI、HPC、科学计算、数字孪生及自动驾驶等诸多前沿领域的技术盛宴。在这场盛宴中,我们不仅看到技术突破如何改变各行各业的生产效率和工作方式,也看到英伟达围绕计算世界的最新布局。

随着新一代大规模云技术的出现,数据中心架构有待转型。未来,NVIDIA将向五个方向发力:Million-X百万倍计算速度飞跃,大幅加快AI速度的Transformers,成为AI工厂的数据中心,对机器人系统的需求呈指数级增长以及下一个AI时代的数字孪生。NVIDIA还将不断提升自身,并帮助合作伙伴、开发者和客户共同发力,让数字孪生技术加速落地,让云宇宙触手可及。